반응형

확률론 맛보기

- 기계학습에서 사용되는 loss function(cost function)은 데이터공간을 통계적으로 해석해서 유도하게됨

- L2 norm은 회귀분석에서 예측오차의 분산을 가장 최소화하는 방향으로 학습한다.

- Cross-entropy는 분류문제에서 모델예측의 불확실성을 최소화하는 방향으로 학습한다.

- 원래 데이터의 확률분포가 이산형이더라도 결합분포를 연속형으로 할 수 있음확률변수 종류

- 확률변수는 분포 D에 의해 구분된다.

1) 이산형 확률변수 - 확률변수가 가질 수 있는 경우의 수를 모두 고려하여 확률을 더해서 모델링함(질량함수)

- 연속하지 않는 값을 이용

\begin{equation}

E(X)=\sum x f(x)

\end{equation}

2) 연속형 확률변수

- 데이터 공간에 정의된 확률변수의 밀도위에서 적분을 통해 모델링함(밀도함수)

- 연속하는 값을 이용

\begin{equation}

\mathbf{E}[\mathbf{X}]=\int_{-\infty}^{\infty} x f(x) d x

\end{equation}

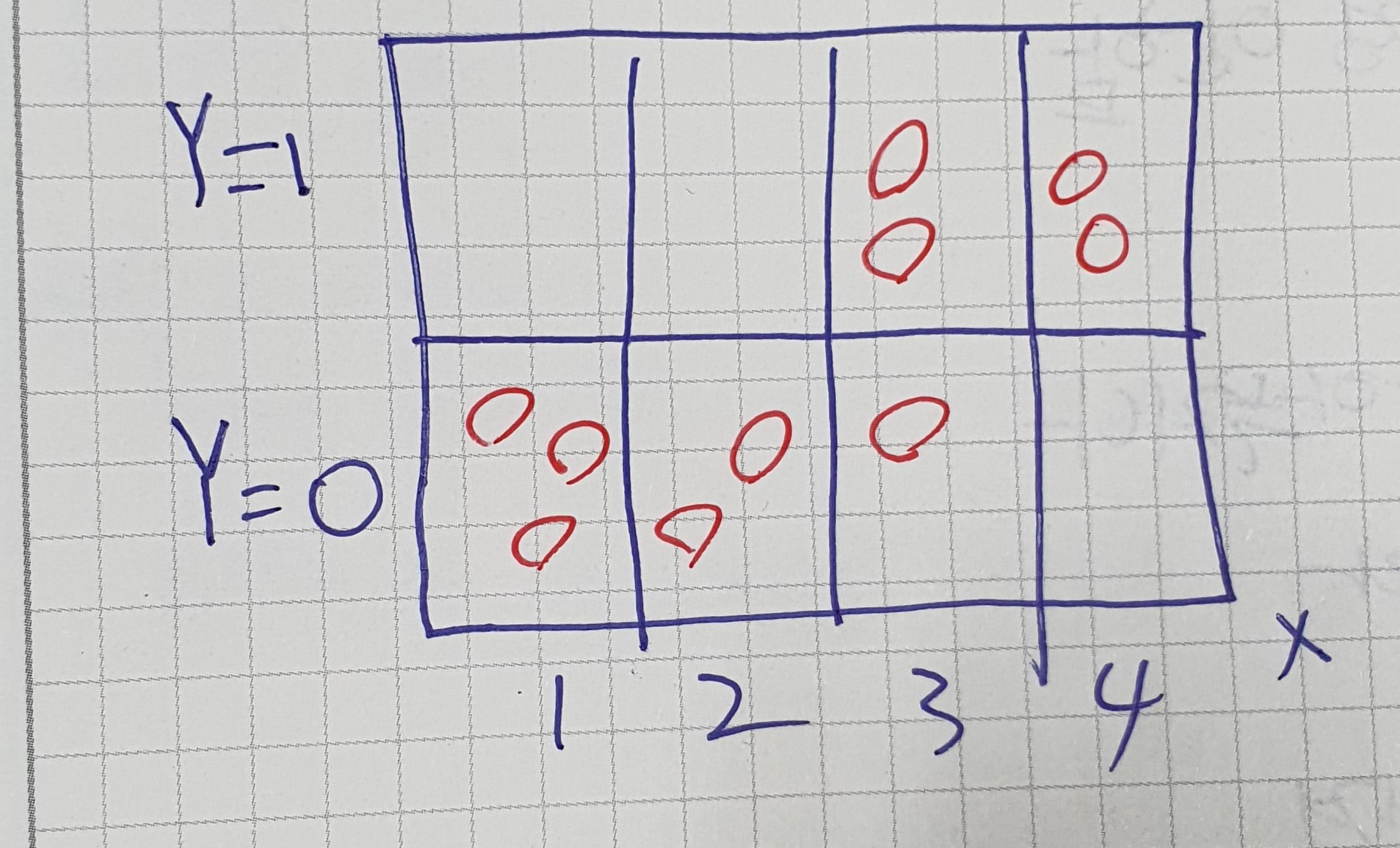

결합분포 P(x,y)

- 결합분포는 결합확률분포라고도 한다.

- 확률 변수가 여러 개일 때 이들을 함께 고려하는 확률 분포이다.

주변확률분포

- 결합분포를 X에따라 이산형일때는 더해주거나 연속형일때는 적분해주면 구할 수 있음

기댓값

- 기댓값은 데이터를 대표하는 통계량으로 평균이라고도 불림

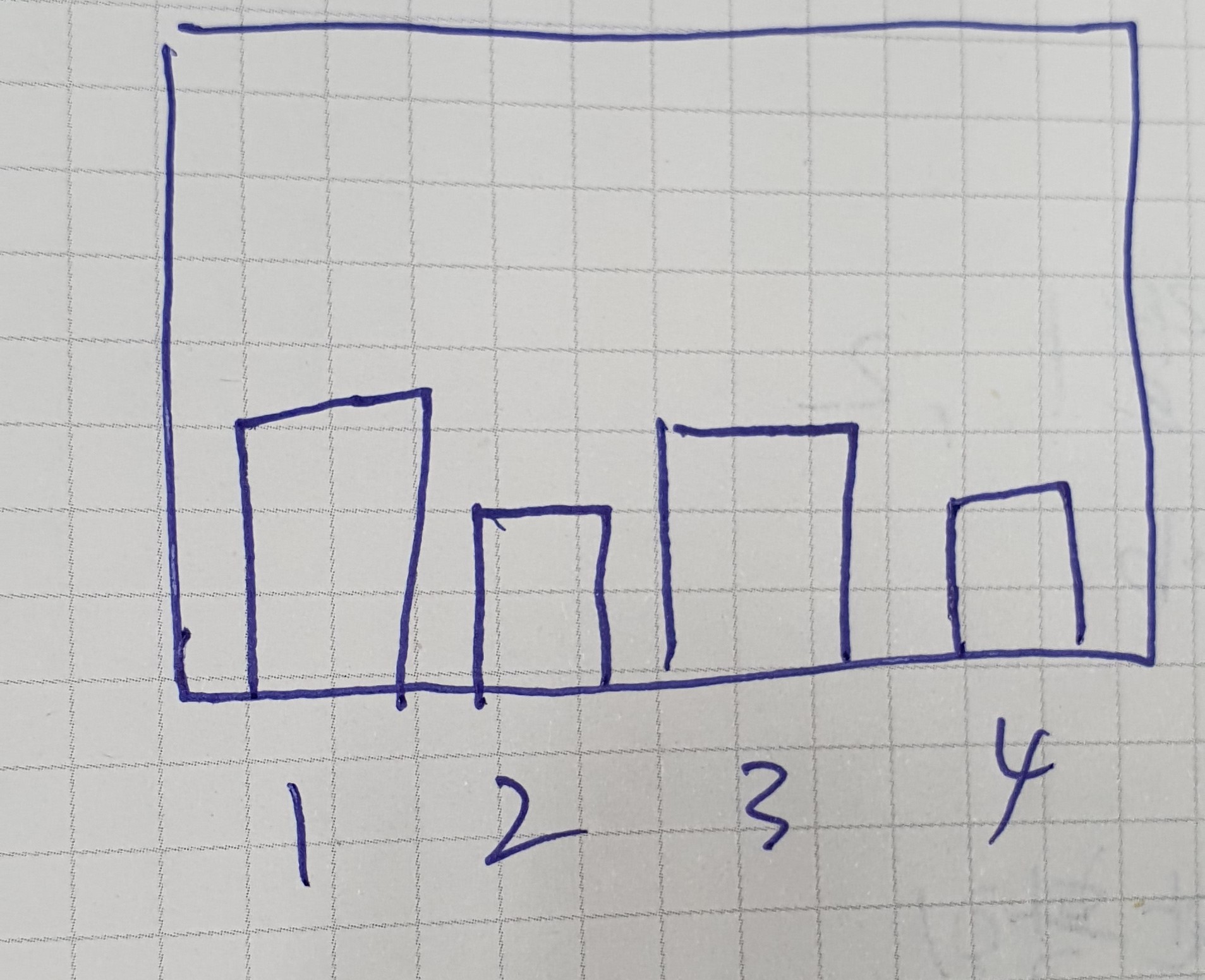

몬테카를로 샘플링

- 확률분포를 모를때 데이터를 이용하여 기대값을 계산할 때 사용

반응형

'부스트캠프 AI Tech 2기 > 2기 U-Stage' 카테고리의 다른 글

| 2주차 MLP (Multi-Layer Perceptron) (0) | 2021.08.09 |

|---|---|

| 2주차 딥러닝에서 사용되는 용어 (0) | 2021.08.09 |

| 1주차 MLE(최대우도법) (0) | 2021.08.09 |

| 1주차 Gradient Descent, Stochastic gradient descent (0) | 2021.08.08 |

| 1주차 - U Stage (0) | 2021.08.06 |