반응형

MLP

여러개의 층으로 쌓으면 단순 행렬곱 연산이지만, 맵핑이 표현할 수 있는 표현력을 극대화하기위해 선형결합만을 n번 반복하는게 아니라

한번 선형결합이 반복될 때마다 activation function을 사용해서 non-linear transform을 거치고 다시 선형변환하고 non-linear transform을거친다. 이 반복을 m번 반복해서 더 표현력이 뛰어난 모델을 만든다.

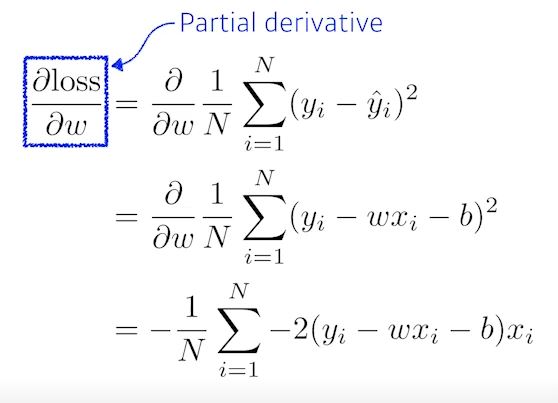

W와 b의 개선방법

위와 같은 데이터가 존재할 때, loss function을 w로 편미분 한 값을 현재 w에 적절한값(스텝사이즈, lr)을 곱해서 빼준다.

bias도 마찬가지로 b로 편미분한 값을 현재 b에 lr을 곱해서 빼준다.

setpsize는 에타 라는 기호를사용

*에타(ETA) : Η η

반응형

'부스트캠프 AI Tech 2기 > 2기 U-Stage' 카테고리의 다른 글

| 2주차 Convolution (0) | 2021.08.12 |

|---|---|

| 2주차 Optimization (0) | 2021.08.10 |

| 2주차 딥러닝에서 사용되는 용어 (0) | 2021.08.09 |

| 1주차 MLE(최대우도법) (0) | 2021.08.09 |

| 1주차 Gradient Descent, Stochastic gradient descent (0) | 2021.08.08 |